딥러닝 학습 optimizer 종류 정리

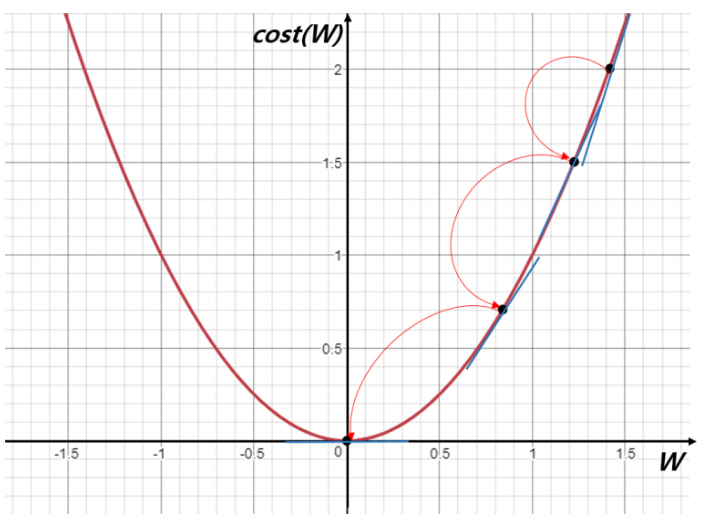

<Gradient descent(GD)>

가장 기본이 되는 optimizer 알고리즘으로 경사를 따라 내려가면서 W를 update시킨다.

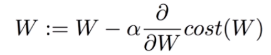

Gradient descent notation

GD를 사용하는 이유

왜 이렇게 기울기를 사용하여 step별로 update를 시키는것일까?

애초에 cost(W)식을 미분하여 0인 점을 찾으면 되는게 아닌가??

내가 알고 있기로 두 가지 이유 때문에 closed form으로 해결하지 못한다고 알고 있다.

1. 대부분의 non-linear regression문제는 closed form solution이 존재하지 않다.